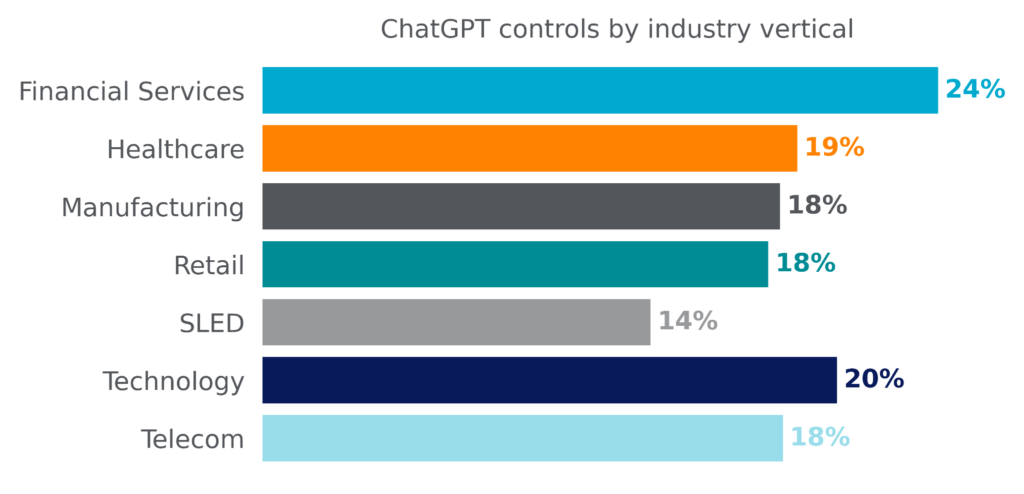

El uso de ChatGPT está aumentando exponencialmente en la empresa, donde los usuarios están enviando información sensible al chat bot, incluyendo código fuente propietario, contraseñas y claves, propiedad intelectual y datos regulados. En respuesta, las organizaciones han establecido controles para limitar el uso de ChatGPT. Los servicios financieros lideran el grupo, con casi una de cada cuatro organizaciones implementando controles en torno a ChatGPT. Este artículo de blog explora qué tipos de controles se han implantado en diversos sectores.

Controles de ChatGPT

Los controles de ChatGPT son más populares en el sector de los servicios financieros, donde casi una de cada cuatro organizaciones ha implantado controles sobre su uso. Como era de esperar, la adopción de ChatGPT también es más baja en los servicios financieros, lo que indica que los controles establecidos en este caso eran en gran medida preventivos, bloqueando a los usuarios de la plataforma.

Curiosamente, una de cada cinco organizaciones tecnológicas dispone de controles ChatGPT, lo que la sitúa en segundo lugar. Sin embargo, estos controles no han tenido el mismo efecto: La adopción de ChatGPT es mayor en las organizaciones tecnológicas. ¿Cómo puede ser esto cierto? La respuesta está en los tipos de controles que se han implementado.

Tipos de controles ChatGPT

Este artículo explora cuatro tipos diferentes de controles que las organizaciones han implementado para supervisar y controlar el uso de ChatGPT.

Políticas de alerta

Las políticas de alerta son controles informativos. Su propósito es únicamente proporcionar visibilidad sobre cómo los usuarios de la organización están interactuando con ChatGPT. A menudo, se combinan con políticas DLP para proporcionar visibilidad de los datos potencialmente sensibles que se publican en ChatGPT. Las políticas de alerta suelen utilizarse durante una fase de aprendizaje para explorar la eficacia y el impacto de un control de bloqueo, y suelen convertirse en políticas de bloqueo después de haber sido ajustadas y probadas.

Políticas de asesoramiento al usuario

Las políticas de asesoramiento al usuario proporcionan contexto a los usuarios que las activan, permitiéndoles decidir si desean continuar o no. Las políticas de asesoramiento al usuario suelen combinarse con las políticas DLP, que pueden utilizarse para notificar al usuario que los datos que está enviando a ChatGPT parecen ser sensibles por naturaleza. Normalmente se recuerda al usuario la política de la empresa y se le pregunta si desea continuar o no. Por ejemplo, si la política de la empresa es no subir código fuente propietario a ChatGPT, pero el usuario está subiendo algún código fuente abierto, puede optar por continuar con el envío después de la notificación. En el caso de las políticas de asesoramiento de usuarios de ChatGPT, los usuarios hacen clic en continuar el 57% de las veces.

Políticas DLP

Las políticas de DLP permiten a las organizaciones acceder a ChatGPT, pero controlan la publicación de datos confidenciales en las instrucciones de entrada. Las políticas DLP son configuradas por la organización para que se activen en cada envío a ChatGPT e inspeccionen el contenido del envío antes de permitir su paso. Las políticas más comunes se centran en código fuente propietario, contraseñas y claves, propiedad intelectual y datos regulados.

Políticas de bloqueo

La política más rigurosa es la que bloquea totalmente el uso de ChatGPT. A los usuarios no se les permite ninguna interacción con la aplicación: no pueden iniciar sesión, enviar instrucciones o, a veces, ni siquiera visitar la propia página de inicio de sesión.

Popularidad de los controles de ChatGPT

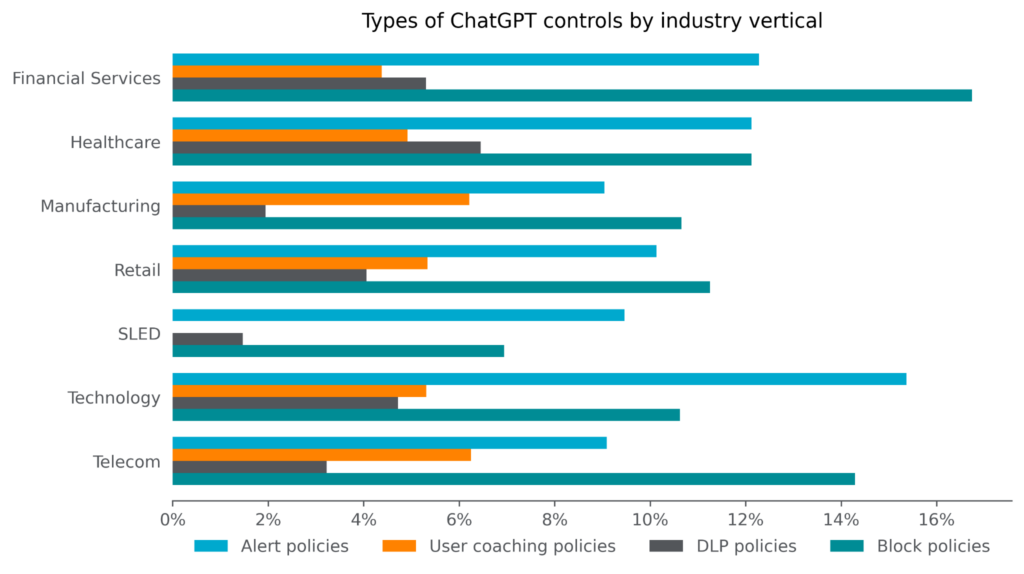

El siguiente gráfico muestra qué porcentaje de organizaciones de cada uno de los siete sectores han implantado cada uno de los tipos de control. Los servicios financieros están a la cabeza en cuanto a políticas de bloqueo, donde casi el 17% de las organizaciones bloquean directamente ChatGPT. Las políticas de DLP que controlan exactamente lo que se puede publicar en ChatGPT también son las más populares entre los servicios financieros y la sanidad, ambos sectores muy regulados. Los gobiernos estatales, locales y las instituciones educativas (SLED) tienen la adopción general más baja de controles de ChatGPT y también la adopción más baja de políticas de asesoramiento de usuarios, políticas DLP y políticas de bloqueo.

Entonces, ¿cómo es que las empresas tecnológicas lideran en términos de uso de ChatGPT y son las segundas en términos de controles de ChatGPT? Los tipos de controles que aplican suelen ser menos severos que los de otras organizaciones. Las organizaciones tecnológicas lideran en cuanto a políticas de sólo alerta diseñadas para proporcionar únicamente visibilidad, y sólo los gobiernos locales, estatales e instituciones educativas tienen un porcentaje menor de organizaciones que promulgan políticas de bloqueo. Las organizaciones tecnológicas utilizan DLP y políticas de asesoramiento de usuarios en porcentajes similares a los de otros sectores. En resumen, lo que esto significa es que las organizaciones tecnológicas tienen como objetivo permitir a sus usuarios el acceso a ChatGPT, al tiempo que supervisan de cerca su uso e implementan controles específicos cuando sea necesario.

Habilitación segura de ChatGPT

Los clientes de Netskope pueden habilitar de forma segura el uso de ChatGPT con control de acceso a aplicaciones, asesoramiento de usuarios en tiempo real y protección de datos.

Acerca de este artículo de blog

Netskope proporciona protección de datos y frente a amenazas a millones de usuarios en todo el mundo. La información presentada en este artículo de blog se basa en datos de uso anonimizados recopilados por la plataforma Netskope Security Cloud relativos a un subconjunto de clientes de Netskope con autorización previa. Las estadísticas se basan en el periodo comprendido entre el 8 de mayo de 2023 y el 4 de junio de 2023. Las estadísticas son un reflejo tanto del comportamiento del usuario como de la política de la organización.

Atrás

Atrás

Lea el blog

Lea el blog