O Cloud and Threat Report deste ano sobre aplicativos de IA concentra-se especificamente nas tendências e nos riscos dos aplicativos de genAI, pois o uso da genAI tem crescido rapidamente com amplo alcance e grande impacto sobre os usuários corporativos. 96% das organizações pesquisadas têm usuários que usam genAI e o número de usuários triplicou nos últimos 12 meses. O uso dos aplicativos genAI no mundo real inclui ajuda com codificação, assistência à escrita, criação de apresentações e geração de vídeos e imagens. Esses casos de uso apresentam desafios de segurança de dados, especificamente como evitar que dados confidenciais, como código-fonte, dados regulamentados e propriedade intelectual, sejam enviados para aplicativos não aprovados.

Começamos este relatório observando as tendências de uso dos aplicativos de genAI, depois analisamos os riscos de base ampla introduzidos pelo uso da genAI, discutimos controles específicos que são eficazes e podem ajudar as organizações a melhorar diante de dados incompletos ou novas áreas de ameaças e terminamos com uma visão das tendências e implicações futuras.

Com base em milhões de atividades anônimas de usuários, o uso do aplicativo genAI passou por mudanças significativas de junho de 2023 a junho de 2024:

- Praticamente todas as organizações agora usam aplicativos genAI, com o uso aumentando de 74% para 96% das organizações no último ano.

- A adoção da GenAI está crescendo rapidamente e ainda não atingiu um estado estável. A organização média usa mais de três vezes o número de aplicativos genAI e tem quase três vezes o número de usuários que usam ativamente esses aplicativos do que há um ano.

- O risco de dados é a principal preocupação dos primeiros usuários de aplicativos genAI, com o compartilhamento de código-fonte proprietário com aplicativos genAI representando 46% de todas as violações da política de dados.

- A adoção de controles de segurança para habilitar com segurança os aplicativos genAI está em alta, com mais de três quartos das organizações usando políticas de bloqueio/permissão, DLP, treinamento de usuários ao vivo e outros controles para habilitar aplicativos genAI e, ao mesmo tempo, proteger os dados.

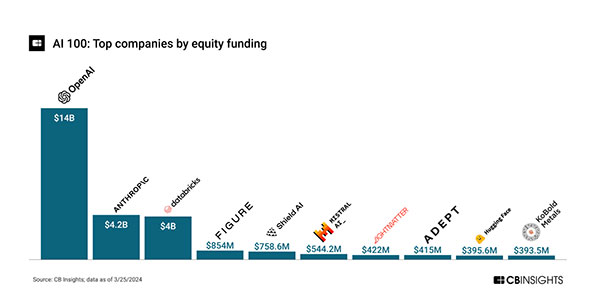

A IA em geral tem sido popular e atraído investimentos consideráveis, com financiamento totalizando mais de US$ 28 bilhões em mais de 240 negócios de capital de 2020 a 22/03/2024[1].

Com a OpenAI e a Anthropic totalizando quase dois terços (64%) do financiamento total, o financiamento da IA é dominado e impulsionado pela genAI. Isso reflete o crescente entusiasmo da genAI desde o lançamento do ChatGPT da OpenAI em novembro de 2022. Além das startups, foram criados vários ETFs e fundos mútuos voltados para IA, o que indica outro nível de financiamento por parte dos investidores do mercado público. O grande volume de investimentos proporcionará um impulso para pesquisa e desenvolvimento, lançamentos de produtos e riscos e abusos associados.

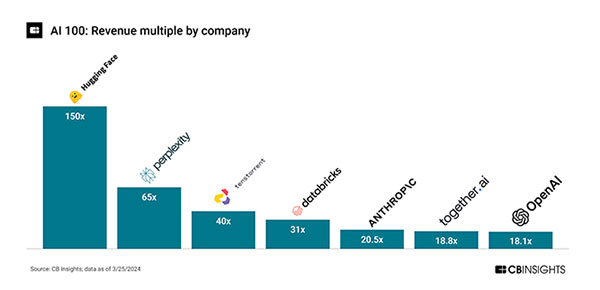

Índices de preço em relação às vendas muito elevados indicam que a execução está aquém das grandes expectativas dos investidores. A Hugging Face tem um múltiplo de 150x de uma avaliação de US$ 4,5 bilhões sobre receitas de US$ 30 milhões e a Perplexity um múltiplo de 65x de uma avaliação de US$ 520 milhões sobre receitas de US$ 8 milhões[1]:

&Embora a receita real esteja atrasada, a atividade de lançamento de produtos é alta, o que indica que ainda estamos no início do ciclo de inovação de IA, com grandes investimentos em P&D. Por exemplo, houve 34 lançamentos de recursos (menores e maiores) do ChatGPT desde novembro de 2022[2], ou aproximadamente dois por mês.

Está claro que a genAI será o motor do investimento em IA no curto prazo e introduzirá o risco e o impacto mais amplos para os usuários corporativos. Ele é ou será incluído por padrão nas principais plataformas de aplicativos, pesquisa e dispositivos, com casos de uso como pesquisa, edição de cópias, ajuste de estilo/tom e criação de conteúdo. O principal risco decorre dos dados que os usuários enviam para os aplicativos, incluindo perda de dados, compartilhamento não intencional de informações confidenciais e uso inadequado de informações (direitos legais) dos serviços da genAI. Atualmente, os textos (LLMs) são mais usados, com seus casos de uso mais amplos, embora os aplicativos genAI para vídeo, imagens e outras mídias também sejam um fator.

Este relatório resume o uso e as tendências da genAI com base em dados anônimos de clientes nos últimos 12 meses, detalhando o uso do aplicativo, as ações do usuário, as áreas de risco e os controles iniciais, além de fornecer orientações prescritivas para os próximos 12 meses.

Voltar

Voltar