Desde o lançamento do ChatGPT em novembro de 2022, a IA generativa (GenAI) passou por uma rápida adoção corporativa. De acordo com os pesquisadores do Netskope Threat Labs, em junho de 2024, surpreendentes 96% das organizações estarão usando vários tipos de aplicativos de genAI. Essa adoção generalizada está transformando a forma como as empresas operam, mas com grande poder vêm grandes responsabilidades e riscos.

A espada de dois gumes de GenAI

O GenAI oferece vários benefícios. Por exemplo, as ferramentas GenAI estão revolucionando a produtividade ao auxiliar na codificação, criação de conteúdo e análise de dados. Essas ferramentas podem automatizar tarefas repetitivas, promover a inovação e fornecer aos funcionários novos recursos que impulsionam a eficiência e a criatividade. No entanto, o alto uso do GenAI também traz riscos significativos, que exigem um gerenciamento atento.

O novo relatório de IA do Netskope Threat Labs enfatiza várias preocupações relacionadas à segurança de dados e ao uso indevido de tecnologias de IA. Um dos problemas mais urgentes é o vazamento de dados.

O vazamento de dados é o compartilhamento de informações confidenciais com as ferramentas GenAI que levam ao vazamento não intencional de dados, expondo propriedades intelectuais valiosas e comprometendo a segurança de sistemas proprietários. O relatório revela que o compartilhamento de código-fonte proprietário com aplicativos genAI é responsável por 46% de todas as violações da política de dados genAI identificadas pela plataforma DLP da Netskope.

Considere um cenário em que um engenheiro de software de uma empresa multinacional de tecnologia usa um aplicativo GenAI para otimizar o código. Sem perceber, o engenheiro compartilha um código proprietário que contém algoritmos confidenciais. Esse código pode ser acessado por pessoas não autorizadas, levando a possíveis violações de dados e desvantagens competitivas.

(O senhor pode saber mais sobre alguns dos problemas neste episódio do podcast Security Visionaries, em que a advogada de PI Suzanne Oliver, o CISO Neil Thacker e o líder do AI Labs, Yihua Liao, discutem as implicações da IA).

Recomendações gerais:

Para se proteger contra esses riscos, as organizações devem:

→ Analise regularmente a atividade, as tendências, os comportamentos e a sensibilidade dos dados dos aplicativos de IA para identificar possíveis ameaças

→ Bloqueie o acesso a aplicativos que não servem para fins comerciais legítimos ou representam um risco desproporcional

→ Use políticas de prevenção de perda de dados para detectar o conteúdo/solicitações contendo informações confidenciais, incluindo código-fonte, dados regulamentados e senhas

Equilibrando inovação e segurança

Embora o GenAI traga eficiência e inovação, há debates contínuos sobre a maneira correta de controlar o uso de certos aplicativos GenAI. Por exemplo, muitos estão tentando determinar se bloquear o acesso a determinados aplicativos, como o GitHub Copilot, é realmente uma medida de segurança apropriada ou se o custo de perder as vantagens de produtividade é muito alto.

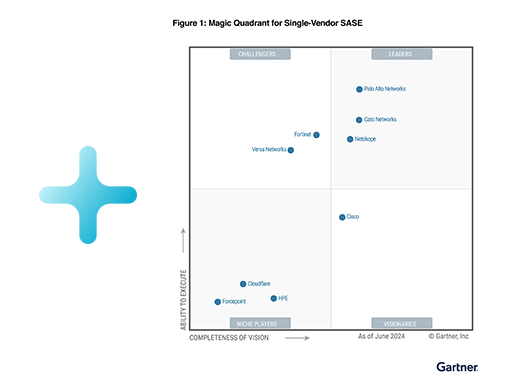

E essas preocupações são válidas. Bloquear esses aplicativos pode não ser a melhor abordagem. Em vez disso, as organizações devem consultar o Netskope Cloud Confidence Index (CCI) para ajudar a decidir quais aplicativos permitir e quais restringir, com base em seus perfis de segurança e conformidade. Os aplicativos são avaliados com base em critérios objetivos adaptados das Orientações da Cloud Security Alliance. Esses critérios medem a prontidão empresarial dos aplicativos, levando em consideração as credenciais de segurança, a capacidade de auditoria e a continuidade dos negócios.

No momento em que este artigo foi escrito, o GitHub Copilot tinha uma pontuação CCI alta de 80 (de 100; lembre-se de que esse número é dinâmico), indicando um nível de confiabilidade acima da média. No entanto, 19% das organizações que usam aplicativos genAI proibiram completamente o GitHub Copilot. A implementação de controles mais granulares para monitorar seu uso e garantir a conformidade dos dados, em vez de impor um bloqueio geral, pode permitir que as organizações se beneficiem de suas capacidades e, ao mesmo tempo, mitiguem os riscos.

Navegando pelo futuro

A IA generativa tem um potencial incrível para impulsionar a inovação e a eficiência nas empresas. No entanto, é crucial estar ciente e trabalhar para reduzir os riscos associados. Ao compreender as ameaças, como vazamento de dados e falsificações profundas, e ao implementar medidas de segurança robustas, as organizações podem aproveitar com segurança o poder do GenAI.

Mantenha-se informado e seguro. Leia o relatório completo do Netskope Threat Labs para equipar sua empresa com o conhecimento necessário para navegar no futuro da IA. Acesse o relatório completo sobre nuvem e ameaças: aplicativos de IA na empresa aqui.

Voltar

Voltar

Leia o Blog

Leia o Blog