-

Pourquoi Netskope

- Pourquoi Netskope

Pourquoi Netskope

Changer la façon dont le réseau et la sécurité fonctionnent ensemble.

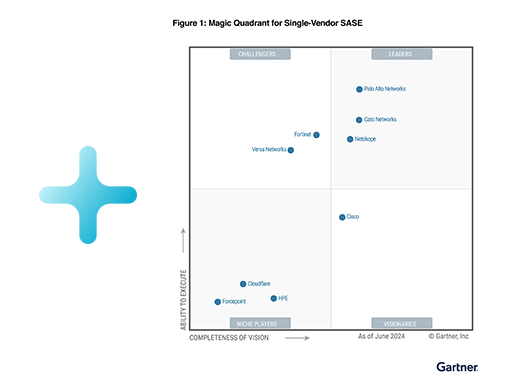

Recevoir le rapportUn leader sur SSE. Désormais leader en matière de SASE à fournisseur unique.Découvrez pourquoi Netskope a été classé parmi les leaders de l'édition 2024 du Gartner® Magic Quadrant™️ pour le Secure Access Service Edge à fournisseur unique.

- Pourquoi Netskope

Nos clients

Netskope sert plus de 3 400 clients dans le monde, dont plus de 30 entreprises du Fortune 100

Obtenir l'EBookCoup de projecteur sur les idées novatrices de nos clientsDécouvrez comment des clients innovants naviguent avec succès dans le paysage évolutif de la mise en réseau et de la sécurité d’aujourd’hui grâce à la plateforme Netskope One.

- Pourquoi Netskope

Nos partenaires

Nous collaborons avec des leaders de la sécurité pour vous aider à sécuriser votre transition vers le cloud.

En savoir plus sur les partenaires de NetskopeLa stratégie de commercialisation de Netskope privilégie ses partenaires, ce qui leur permet de maximiser leur croissance et leur rentabilité, tout en transformant la sécurité des entreprises.

-

Plateforme

- Plateforme

Plate-forme Netskope One

Netskope One est une plate-forme convergente de sécurité et de réseau en tant que service.

Obtenir le livre blancLe réseau de demainPlanifiez votre chemin vers un réseau plus rapide, plus sûr et plus résilient, conçu pour les applications et les utilisateurs que vous prenez en charge.

- Plateforme

Partenaires technologiques et intégrations

Netskope s'associe aux sociétés les plus performantes en matière de technologies destinées aux entreprises.

En savoir plus sur Cloud ExchangeNetskope Cloud ExchangeLe Netskope Cloud Exchange (CE) fournit aux clients des outils d'intégration puissants pour optimiser les investissements dans l'ensemble de leur infrastructure de sécurité.

-

Produits

- Produits

Security Service Edge

Protégez-vous contre les menaces avancées et compatibles avec le cloud et protégez les données sur tous les vecteurs.

Présentation des produitsLa plateforme du futur est NetskopeSecurity Service Edge (SSE), Cloud Access Security Broker (CASB), Cloud Firewall, Next Generation Secure Web Gateway (SWG), et Private Access for ZTNA intégrés nativement dans une solution unique pour aider chaque entreprise dans son cheminement vers l'architecture Secure Access Service Edge (SASE).

- Security Service Edge

- Enterprise Browser

- Next Gen Secure Web Gateway (SWG)

- Pare-feu

- Remote Browser Isolation

- Cloud Access Security Broker

- Gestion du niveau de sécurité SaaS

- Private Access

- Sécurité des données

- Gestion de la sécurité des données

- Prévention des pertes de données

- Intelligence des dispositifs

- Protection contre les menaces

- Security Service Edge

- Produits

SD-WAN

Fournissez en toute confiance un accès sécurisé et performant à chaque utilisateur, appareil, site et cloud distant.

En savoir plus Next Gen SASE BranchNext Gen SASE Branch est hybride - connectée, sécurisée et automatiséeNetskope Next Gen SASE Branch fait converger Context-Aware SASE Fabric, Zero-Trust Hybrid Security et SkopeAI-Powered Cloud Orchestrator dans une offre cloud unifiée, ouvrant la voie à une expérience de succursale entièrement modernisée pour l'entreprise sans frontières.

- Produits

Secure Access Service Edge

Netskope One SASE fournit une solution SASE cloud-native, entièrement convergée et à fournisseur unique.

Obtenir l'EBookL'architecture SASE pour les nulsObtenez votre exemplaire gratuit du seul guide consacré à la conception d'une architecture SASE dont vous aurez jamais besoin.

-

Solutions

- Solutions

Transformation du réseau

Gagnez en agilité et en efficacité grâce à la transformation numérique.

Aller à l'aperçu des solutionsDécouvrez NewEdgeOptez pour les meilleurs services de sécurité cloud du marché, avec un temps de latence minimum et une fiabilité élevée. - Solutions

Modernisation de la sécurité

Relevez les défis de sécurité d'aujourd'hui et de demain.

Découvrez comment nous sécurisons l'utilisation de l'IA générativePermettez en toute sécurité l'utilisation d'applications d'IA générative grâce au contrôle d'accès aux applications, à l'accompagnement des utilisateurs en temps réel et à une protection des données de premier ordre.- Protection avancée contre les menaces

- Travail hybride

- Risques internes

- Maintien de la conformité

- Remplacer les VPN

- Autorisez ChatGPT et l’IA générative en toute sécurité

- Applications cloud gérées sécurisées

- Sécuriser les applications cloud non gérées

- AWS, Azure et GCP

- Protection avancée contre les menaces

- Solutions

Cadres

Adoptez les cadres réglementaires qui façonnent la cybersécurité.

Aller à l'aperçu des solutionsEn savoir plus sur la confiance zéroSolutions Zero Trust pour les déploiements du SSE et du SASE - Solutions

Gouvernements et industries

Netskope aide les plus grandes agences et entreprises du monde à sécuriser leur passage à l'informatique dématérialisée.

En savoir plus sur Netskope GovCloudNetskope obtient l'autorisation FedRAMP High AuthorizationChoisissez Netskope GovCloud pour accélérer la transformation de votre agence.

- Services financiers et d'assurance

- Santé et sciences de la vie

- Haute technologie

- Établissements d'enseignement supérieur

- Enseignement primaire et secondaire

- Juridique

- Production industrielle

- US Public Sector

- UK Public Sector

- Gouvernement australien

- Commerce de détail et hébergement

- Sociétés de services

- Utilities

- Services financiers et d'assurance

-

Ressources

- Ressources

Ressources

Découvrez comment Netskope peut vous aider à sécuriser votre migration vers le Cloud.

Écouter le podcast Parcourir tous les podcastsPodcast Security VisionariesAborder la sécurité d'un point de vue non technique

Max Havey et son invitée Savannah Westbrock discutent de la manière d'aborder des rôles plus axés sur la sécurité lorsque l'on vient d'un milieu non technique. - Ressources

Blog

Découvrez comment Netskope permet la transformation de la sécurité et de la mise en réseau grâce à l'accès sécurisé à la périphérie des services (SASE).

Lire le blogDerniers blogsDécouvrez comment Netskope peut faciliter le parcours Zero Trust et SASE grâce à des capacités d'accès sécurisé à la périphérie des services (SASE).

- Ressources

Événements et ateliers

Restez à l'affût des dernières tendances en matière de sécurité et créez des liens avec vos pairs.

Explorer les sessionsSASE Week 2024 A la demandeApprenez à naviguer dans les dernières avancées en matière de SASE et de confiance zéro et découvrez comment ces cadres s'adaptent pour répondre aux défis de la cybersécurité et de l'infrastructure.

- Ressources

Définition de la sécurité

Tout ce que vous devez savoir dans notre encyclopédie de la cybersécurité.

En savoir plus sur SASEQu'est-ce que SASE ?Découvrez la future convergence des outils réseau et sécurité dans le modèle économique actuel, dominé par le cloud.

- Aperçu de la définition de la sécurité

- Qu'est-ce que SASE ?

- Qu'est-ce que le Security Service Edge ?

- Qu'est-ce qu'un CASB ?

- Qu'est-ce que l'accès au réseau sans confiance (ZTNA) ?

- Qu'est-ce qu'une passerelle Web sécurisée (SWG) de nouvelle génération ?

- Qu'est-ce que la prévention des pertes de données (DLP) ?

- Qu'est-ce que le SD-WAN ?

- Qu'est-ce que l'IA générative ?

- ¿Qué es SSPM?

- Qu'est-ce que FedRamp ?

- Aperçu de la définition de la sécurité

-

Entreprise

- Entreprise

Entreprise

Nous vous aidons à conserver une longueur d'avance sur les défis posés par le cloud, les données et les réseaux en matière de sécurité.

En savoir plusSoutenir le développement durable par la sécurité des donnéesNetskope est fière de participer à Vision 2045 : une initiative visant à sensibiliser au rôle de l'industrie privée dans le développement durable.

- Entreprise

Carrières

Rejoignez les 3 000 membres de l'équipe de Netskope qui construisent la première plateforme de sécurité cloud-native du secteur.

Rejoignez l’équipeContribuez à façonner l'avenir de la sécurité du cloudAt Netskope, founders and leaders work shoulder-to-shoulder with their colleagues, even the most renowned experts check their egos at the door, and the best ideas win.

- Entreprise

Solutions pour les clients

Nous sommes là pour vous et avec vous à chaque étape, pour assurer votre succès avec Netskope.

Aller à Solutions clientsLes professionnels du service et de l'assistance de Netskope veilleront à ce que vous puissiez déployer avec succès notre plateforme et en tirer toute la valeur.- Services professionnels

- Suivi de nos clients

- Soutien technique

- Partenaires de prestation de services

- Communauté de clients

- Documentation produit

- Support Portal

- Trust Portal

- Services professionnels

- Entreprise

Formation et accréditations

Avec Netskope, devenez un expert de la sécurité du cloud.

En savoir plus sur les formations et les certificationsSécurisez votre parcours de transformation numérique et tirez le meilleur parti de vos applications cloud, Web et privées grâce à la formation Netskope.- Introduction technique à Netskope Security Cloud - online

- Opérations et administration de Netskope Security Cloud (NSCO&A)

- Mise en œuvre et intégration du cloud de sécurité Netskope (NSCI&I)

- Introduction technique à Netskope Security Cloud - online

- Pourquoi Netskope

Changer la façon dont le réseau et la sécurité fonctionnent ensemble.

- Nos clients

Netskope sert plus de 3 400 clients dans le monde, dont plus de 30 entreprises du Fortune 100

- Nos partenaires

Nous collaborons avec des leaders de la sécurité pour vous aider à sécuriser votre transition vers le cloud.

Découvrez pourquoi Netskope a été classé parmi les leaders de l'édition 2024 du Gartner® Magic Quadrant™️ pour le Secure Access Service Edge à fournisseur unique.

Recevoir le rapport

Découvrez comment des clients innovants naviguent avec succès dans le paysage évolutif de la mise en réseau et de la sécurité d’aujourd’hui grâce à la plateforme Netskope One.

Obtenir l'EBook

- Plate-forme Netskope One

Netskope One est une plate-forme convergente de sécurité et de réseau en tant que service.

- Partenaires technologiques et intégrations

Netskope s'associe aux sociétés les plus performantes en matière de technologies destinées aux entreprises.

Planifiez votre chemin vers un réseau plus rapide, plus sûr et plus résilient, conçu pour les applications et les utilisateurs que vous prenez en charge.

Obtenir le livre blanc

Le Netskope Cloud Exchange (CE) fournit aux clients des outils d'intégration puissants pour optimiser les investissements dans l'ensemble de leur infrastructure de sécurité.

En savoir plus sur Cloud Exchange

- Security Service Edge

Protégez-vous contre les menaces avancées et compatibles avec le cloud et protégez les données sur tous les vecteurs.

- SD-WAN

Fournissez en toute confiance un accès sécurisé et performant à chaque utilisateur, appareil, site et cloud distant.

- Secure Access Service Edge

Netskope One SASE fournit une solution SASE cloud-native, entièrement convergée et à fournisseur unique.

- Security Service Edge

- Enterprise Browser

- Next Gen Secure Web Gateway (SWG)

- Pare-feu

- Remote Browser Isolation

- Cloud Access Security Broker

- Gestion du niveau de sécurité SaaS

- Private Access

- Sécurité des données

- Gestion de la sécurité des données

- Prévention des pertes de données

- Intelligence des dispositifs

- Protection contre les menaces

Security Service Edge (SSE), Cloud Access Security Broker (CASB), Cloud Firewall, Next Generation Secure Web Gateway (SWG), et Private Access for ZTNA intégrés nativement dans une solution unique pour aider chaque entreprise dans son cheminement vers l'architecture Secure Access Service Edge (SASE).

Présentation des produits

Netskope Next Gen SASE Branch fait converger Context-Aware SASE Fabric, Zero-Trust Hybrid Security et SkopeAI-Powered Cloud Orchestrator dans une offre cloud unifiée, ouvrant la voie à une expérience de succursale entièrement modernisée pour l'entreprise sans frontières.

En savoir plus Next Gen SASE Branch

Obtenez votre exemplaire gratuit du seul guide consacré à la conception d'une architecture SASE dont vous aurez jamais besoin.

Obtenir l'EBook

- Transformation du réseau

Gagnez en agilité et en efficacité grâce à la transformation numérique.

- Modernisation de la sécurité

Relevez les défis de sécurité d'aujourd'hui et de demain.

- Cadres

Adoptez les cadres réglementaires qui façonnent la cybersécurité.

- Gouvernements et industries

Netskope aide les plus grandes agences et entreprises du monde à sécuriser leur passage à l'informatique dématérialisée.

- Protection avancée contre les menaces

- Travail hybride

- Risques internes

- Maintien de la conformité

- Remplacer les VPN

- Autorisez ChatGPT et l’IA générative en toute sécurité

- Applications cloud gérées sécurisées

- Sécuriser les applications cloud non gérées

- AWS, Azure et GCP

- Services financiers et d'assurance

- Santé et sciences de la vie

- Haute technologie

- Établissements d'enseignement supérieur

- Enseignement primaire et secondaire

- Juridique

- Production industrielle

- US Public Sector

- UK Public Sector

- Gouvernement australien

- Commerce de détail et hébergement

- Sociétés de services

- Utilities

Choisissez Netskope GovCloud pour accélérer la transformation de votre agence.

En savoir plus sur Netskope GovCloud

- Ressources

Découvrez comment Netskope peut vous aider à sécuriser votre migration vers le Cloud.

- Blog

Découvrez comment Netskope permet la transformation de la sécurité et de la mise en réseau grâce à l'accès sécurisé à la périphérie des services (SASE).

- Événements et ateliers

Restez à l'affût des dernières tendances en matière de sécurité et créez des liens avec vos pairs.

- Définition de la sécurité

Tout ce que vous devez savoir dans notre encyclopédie de la cybersécurité.

- Aperçu de la définition de la sécurité

- Qu'est-ce que SASE ?

- Qu'est-ce que le Security Service Edge ?

- Qu'est-ce qu'un CASB ?

- Qu'est-ce que l'accès au réseau sans confiance (ZTNA) ?

- Qu'est-ce qu'une passerelle Web sécurisée (SWG) de nouvelle génération ?

- Qu'est-ce que la prévention des pertes de données (DLP) ?

- Qu'est-ce que le SD-WAN ?

- Qu'est-ce que l'IA générative ?

- ¿Qué es SSPM?

- Qu'est-ce que FedRamp ?

Aborder la sécurité d'un point de vue non technique

Max Havey et son invitée Savannah Westbrock discutent de la manière d'aborder des rôles plus axés sur la sécurité lorsque l'on vient d'un milieu non technique.

Découvrez comment Netskope peut faciliter le parcours Zero Trust et SASE grâce à des capacités d'accès sécurisé à la périphérie des services (SASE).

Lire le blog

Apprenez à naviguer dans les dernières avancées en matière de SASE et de confiance zéro et découvrez comment ces cadres s'adaptent pour répondre aux défis de la cybersécurité et de l'infrastructure.

Explorer les sessions

Découvrez la future convergence des outils réseau et sécurité dans le modèle économique actuel, dominé par le cloud.

En savoir plus sur SASE

- Entreprise

Nous vous aidons à conserver une longueur d'avance sur les défis posés par le cloud, les données et les réseaux en matière de sécurité.

- Carrières

Rejoignez les 3 000 membres de l'équipe de Netskope qui construisent la première plateforme de sécurité cloud-native du secteur.

- Solutions pour les clients

Nous sommes là pour vous et avec vous à chaque étape, pour assurer votre succès avec Netskope.

- Formation et accréditations

Avec Netskope, devenez un expert de la sécurité du cloud.

Netskope est fière de participer à Vision 2045 : une initiative visant à sensibiliser au rôle de l'industrie privée dans le développement durable.

En savoir plus

At Netskope, founders and leaders work shoulder-to-shoulder with their colleagues, even the most renowned experts check their egos at the door, and the best ideas win.

Rejoignez l’équipe

)

)

Lire le blog

Lire le blog