Le rapport sur le cloud et les menaces de cette année sur les applications d’IA se concentre spécifiquement sur les tendances et les risques des applications genAI, car l’utilisation de genAI a connu une croissance rapide avec une large portée et un impact considérable sur les utilisateurs d’entreprise. 96 % des organisations interrogées ont des utilisateurs utilisant genAI, le nombre d’utilisateurs ayant triplé au cours des 12 derniers mois. L’utilisation réelle des applications genAI comprend l’aide au codage, l’aide à la rédaction, la création de présentations et la génération de vidéos et d’images. Ces cas d’utilisation présentent des défis en matière de sécurité des données, en particulier comment empêcher l’envoi de données sensibles, telles que le code source, les données réglementées et la propriété intellectuelle, à des applications non approuvées.

Nous commençons ce rapport en examinant les tendances d’utilisation des applications genAI, puis nous analysons les risques généralisés introduits par l’utilisation de genAI, discutons des contrôles spécifiques qui sont efficaces et peuvent aider les organisations à s’améliorer face à des données incomplètes ou à de nouvelles zones de menace, et terminons par un regard sur les tendances et les implications futures.

Sur la base de millions d’activités d’utilisateurs anonymisées, l’utilisation de l’application genAI a connu des changements significatifs de juin 2023 à juin 2024 :

- Pratiquement toutes les organisations utilisent maintenant des applications genAI, leur utilisation étant passée de 74 % à 96 % au cours de la dernière année.

- L’adoption de GenAI augmente rapidement et n’a pas encore atteint un état stable. L’entreprise moyenne utilise plus de trois fois plus d’applications genAI et compte près de trois fois plus d’utilisateurs qui utilisent activement ces applications qu’il y a un an.

- Le risque lié aux données est une priorité pour les premiers utilisateurs des applications genAI, le partage de code source propriétaire avec les applications genAI représentant 46 % de toutes les violations de la politique de données.

- L’adoption de contrôles de sécurité pour activer en toute sécurité les applications genAI est en hausse, avec plus des trois quarts des organisations utilisant des politiques de blocage/autorisation, DLP (Prévention des pertes de données), coaching des utilisateurs en direct et d’autres contrôles pour activer les applications genAI tout en protégeant les données.

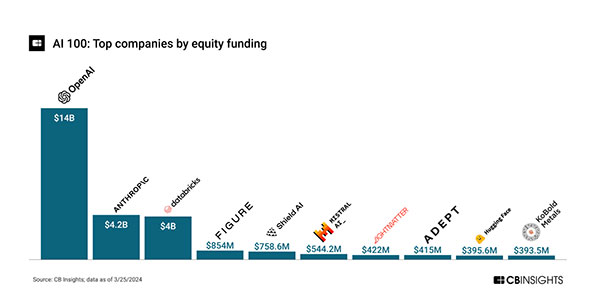

L’IA en général a été populaire et a attiré des investissements considérables, avec un financement totalisant plus de 28 milliards de dollars à travers 240+ transactions d’actions de 2020 au 22/03/2024.[1]

Avec OpenAI et Anthropic totalisant près des deux tiers (64 %) du financement total, le financement de l’IA est dominé et piloté par genAI. Cela reflète l’enthousiasme croissant de genAI depuis la sortie de ChatGPT d’OpenAI en novembre 2022. En plus des startups, plusieurs ETF et fonds communs de placement axés sur l’IA ont été créés, ce qui indique un autre niveau de financement de la part des investisseurs du marché public. Le montant important des investissements fournira un vent arrière pour la recherche et le développement, les lancements de produits et les risques et abus associés.

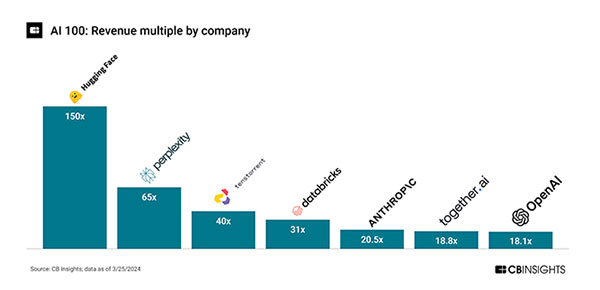

Des ratios cours/ventes démesurés indiquent que l’exécution est à la traîne par rapport aux attentes élevées des investisseurs. Hugging Face a un multiple de 150x d’une valorisation de 4,5 milliards de dollars sur un chiffre d’affaires de 30 millions de dollars et Perplexity un multiple de 65x d’une valorisation de 520 millions de dollars sur un chiffre d’affaires de 8 millions de dollars[1]:

Bien que le chiffre d’affaires réel soit à la traîne, l’activité de lancement de produits est élevée, ce qui indique que nous sommes encore au début du cycle d’innovation de l’IA avec de lourds investissements en R&D. À titre d’exemple, il y a eu 34 versions de fonctionnalités (mineures et majeures) de ChatGPT depuis novembre 2022[2], soit environ deux par mois.

Il est clair que genAI sera le moteur de l’investissement dans l’IA à court terme et qu’elle introduira le risque et l’impact les plus larges pour les utilisateurs d’entreprise. Il est ou sera regroupé par défaut sur les principales plates-formes d’applications, de recherche et périphériques, avec des cas d’utilisation tels que la recherche, la révision, l’ajustement du style/ton et la création de contenu. Le risque principal découle des données que les utilisateurs envoient aux applications, notamment la perte de données, le partage involontaire d’informations confidentielles et l’utilisation inappropriée des informations (droits légaux) des services genAI. Actuellement, le texte (LLM) est plus utilisé, avec leurs cas d’utilisation plus larges, bien que les applications genAI pour la vidéo, les images et d’autres médias soient également un facteur.

Ce rapport résume l’utilisation et les tendances de genAI sur la base de données clients anonymisées au cours des 12 derniers mois, détaillant l’utilisation des applications, les actions des utilisateurs, les zones de risque et les contrôles précoces, tout en fournissant des conseils normatifs pour les 12 prochains mois.

Retour

Retour