Der diesjährige Cloud- und Bedrohungsbericht zu KI-Apps konzentriert sich speziell auf Trends und Risiken bei GenAI-Anwendungen, da die Verwendung von GenAI schnell zunimmt und eine große Reichweite und weitreichende Auswirkungen auf Unternehmensbenutzer hat. 96 % der befragten Organisationen haben Benutzer, die genAI verwenden, wobei sich die Anzahl der Benutzer in den letzten 12 Monaten verdreifacht hat. Der praktische Einsatz der genAI-Apps umfasst Hilfe beim Codieren, Schreibunterstützung, das Erstellen von Präsentationen sowie die Video- und Bildgenerierung. Diese Anwendungsfälle stellen Herausforderungen für die Datensicherheit dar. Insbesondere geht es darum, zu verhindern, dass vertrauliche Daten wie Quellcode, regulierte Daten und geistiges Eigentum an nicht genehmigte Apps gesendet werden.

Wir beginnen diesen Bericht mit einem Blick auf die Verwendungstrends bei genAI-Anwendungen. Anschließend analysieren wir die breit angelegten Risiken, die durch die Verwendung von genAI entstehen, diskutieren spezifische Kontrollen, die wirksam sind und Unternehmen dabei helfen können, sich angesichts unvollständiger Daten oder neuer Bedrohungsbereiche zu verbessern, und beenden den Bericht mit einem Blick auf künftige Trends und Auswirkungen.

Basierend auf Millionen anonymisierter Benutzeraktivitäten hat die Nutzung der genAI-App von Juni 2023 bis Juni 2024 erhebliche Veränderungen erfahren:

- Nahezu alle Organisationen nutzen mittlerweile genAI-Anwendungen. Im letzten Jahr ist die Nutzung von 74 % auf 96 % der Organisationen gestiegen.

- Die Akzeptanz von GenAI nimmt rasch zu, hat aber noch kein stabiles Niveau erreicht. Im durchschnittlichen Unternehmen kommen mehr als dreimal so viele GenAI-Apps zum Einsatz und die Zahl der Benutzer, die diese Apps aktiv nutzen, ist fast dreimal so hoch wie noch vor einem Jahr.

- Das Datenrisiko ist für die ersten Anwender von GenAI-Apps das wichtigste Thema, denn die Weitergabe von proprietärem Quellcode an GenAI-Apps ist für 46 % aller Verstöße gegen die Datenschutzrichtlinien verantwortlich.

- Die Einführung von Sicherheitskontrollen zur sicheren Aktivierung von GenAI-Apps nimmt zu. Mehr als drei Viertel der Organisationen verwenden Blockierungs-/Zulassungsrichtlinien, DLP, Live-Benutzercoaching und andere Kontrollen, um GenAI-Apps zu aktivieren und gleichzeitig die Daten zu schützen.

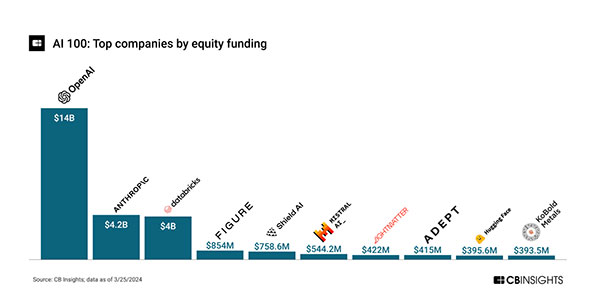

KI erfreut sich allgemein großer Beliebtheit und zieht beträchtliche Investitionen an. Von 2020 bis zum 22.03.2024 wurden im Rahmen von über 240 Beteiligungsgeschäften insgesamt über 28 Milliarden US-Dollar finanziert.[1]

Da OpenAI und Anthropic zusammen fast zwei Drittel (64 %) der Gesamtfinanzierung ausmachen, wird die KI-Finanzierung von genAI dominiert und vorangetrieben. Dies spiegelt die zunehmende Begeisterung für GenAI seit der Veröffentlichung von ChatGPT von OpenAI im November 2022 wider. Zusätzlich zu den Start-ups wurden zahlreiche ETFs und Investmentfonds mit KI-Schwerpunkt aufgelegt, was auf eine weitere Finanzierungsebene durch öffentliche Marktinvestoren schließen lässt. Die hohen Investitionen werden der Forschung und Entwicklung, der Markteinführung neuer Produkte sowie den damit verbundenen Risiken und Missbräuchen Rückenwind verleihen.

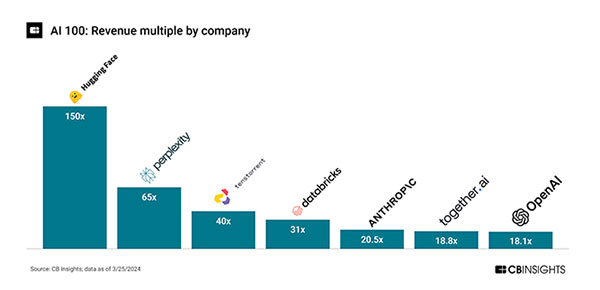

Überhöhte Kurs-Umsatz-Verhältnisse deuten darauf hin, dass die Umsetzung hinter den hohen Erwartungen der Anleger zurückbleibt. Hugging Face hat eine 150-fache Bewertung von 4,5 Milliarden Dollar bei einem Umsatz von 30 Millionen Dollar und Perplexity eine 65-fache Bewertung von 520 Millionen Dollar bei einem Umsatz von 8 Millionen Dollar[1]:

Auch wenn die realen Umsätze zurückbleiben, herrscht eine hohe Aktivität bei der Produktveröffentlichung. Das deutet darauf hin, dass wir uns noch in der Frühphase des KI-Innovationszyklus befinden und hohe Investitionen in Forschung und Entwicklung tätigen. Beispielsweise gab es seit November 2022 34 Feature-Releases (kleinere und größere) von ChatGPT[2], also etwa zwei pro Monat.

Es ist klar, dass genAI kurzfristig der Treiber von KI-Investitionen sein wird und für Unternehmensbenutzer die größten Risiken und Auswirkungen mit sich bringt. Es ist oder wird standardmäßig auf den wichtigsten Anwendungs-, Such- und Geräteplattformen gebündelt sein, mit Anwendungsfällen wie Suche, Textbearbeitung, Stil-/Ton-Anpassung und Inhaltserstellung. Das Hauptrisiko geht von den Daten aus, die Benutzer an die Apps senden. Dazu gehören Datenverlust, unbeabsichtigte Weitergabe vertraulicher Informationen und unangemessene Verwendung von Informationen (gesetzliche Rechte) aus genAI-Diensten. Derzeit werden aufgrund der breiteren Anwendungsfälle mehr Texte (LLMs) verwendet, obwohl auch GenAI-Apps für Videos, Bilder und andere Medien eine Rolle spielen.

Dieser Bericht fasst die Nutzung und Trends von genAI auf der Grundlage anonymisierter Kundendaten der letzten 12 Monate zusammen, beschreibt ausführlich die Anwendungsnutzung, Benutzeraktionen, Risikobereiche und frühen Kontrollen und bietet verbindliche Leitlinien für die nächsten 12 Monate.

Zurück

Zurück